Wir befinden uns jetzt am Anfang des Jahres 2023 und künstliche Intelligenz erhält mehr Aufmerksamkeit denn je. Sie ist bereits ein Teil unseres täglichen Lebens. Wir nutzen sie in unseren Häusern, in unseren Autos, in unseren Büros, in unseren Schulen, in unseren Krankenhäusern, in unseren Fabriken, in unseren Städten, in unserer Welt. Sie hilft uns, unser Leben einfacher, besser, produktiver und gesünder zu gestalten. ChatGPT und DALL-E 2 wurden letztes Jahr vorgestellt, und ich glaube, da wurde vielen Menschen zum ersten Mal bewusst, wie leistungsfähig eine KI sein kann. Beide Tools gehören zur GPT-3-Familie.

In diesem Blogeintrag möchten wir die Grenzen und die Verantwortung aufzeigen, die wir als Ingenieure übernehmen müssen. Über GPT «Generative Pre-trained Transformer» und seine Grenzen haben wir bereits in unserem früheren Blogbeitrag über AI Art - Bilder mit Worten generieren gesprochen und sogar eine Valentinstagskarte erstellt, die ausschliesslich auf KI basiert.

Einige von Ihnen werden sich vielleicht fragen: «Wird KI mich ersetzen» oder sogar «Wird KI uns zerstören», wie in vielen Science-Fiction-Filmen. Wenn Sie über die Verantwortung der KI lesen, kommen Sie wahrscheinlich auf die «Three Laws of Robotics» von Isaac Asimov aus dem Jahr 1942 zurück. Eines davon lautet: «A robot may not harm humanity, or, by inaction, allow humanity to come to harm». Gegenwärtig gibt es nur wenige Gesetze, die die Schöpfer von KI dazu verpflichten, für die Handlungen und Schäden, die eine KI der Welt zufügen könnte, verantwortlich zu sein. Die Wahrheit ist jedoch, dass die KI uns nicht schaden wird, sondern die Menschen, die sie erschaffen.

Die Angst vor der Übernahme der Menschheit durch eine KI und dem damit verbundenen Schaden wurzelt in der Vorstellung, dass Maschinen autonom werden und ohne menschliches Eingreifen arbeiten können. Es wird oft über den Begriff der Singularität diskutiert: Die Singularität bezieht sich auf einen hypothetischen Punkt in der Zukunft, an dem die künstliche Intelligenz die menschliche Intelligenz übertrifft und sich selbst verbessern kann. Auch wenn der Aufstieg der KI exponentiell verläuft, ist sie lediglich ein Werkzeug, das von Menschen entworfen, geschaffen und betrieben wird. KI kann zwar so programmiert werden, dass sie komplexe Aufgaben ausführen und Entscheidungen treffen kann, aber sie unterliegt immer noch den Beschränkungen ihrer Programmierung und der Daten, auf die sie trainiert wurde. In der KI-Forschung gibt es einige wichtige Dinge zu beachten, wenn man versucht, eine verantwortungsvolle KI zu entwickeln:

Voreingenommenheit

KI-Modelle werden anhand eines grossen Datensatzes von Texten aus dem Internet trainiert, die Vorurteile und Stereotypen enthalten können. Dies kann dazu führen, dass das Modell voreingenommene, diskriminierende Ergebnisse oder falsche Aussagen produziert. Eine Liste der Voreingenommenheiten finden Sie in einem Blogbeitrag von Google: Fairness: Arten von Vorurteilen | Maschinelles Lernen | Google Developers

We cannot argue that a pedestrian detector is safe simply because it performs well on a large data set, because that data set may well omit important, but rare, phenomena (for example, people mounting bicycles). We wouldn’t want our automated driver to run over a pedestrian who happened to do something unusual.

Fehlinformationen

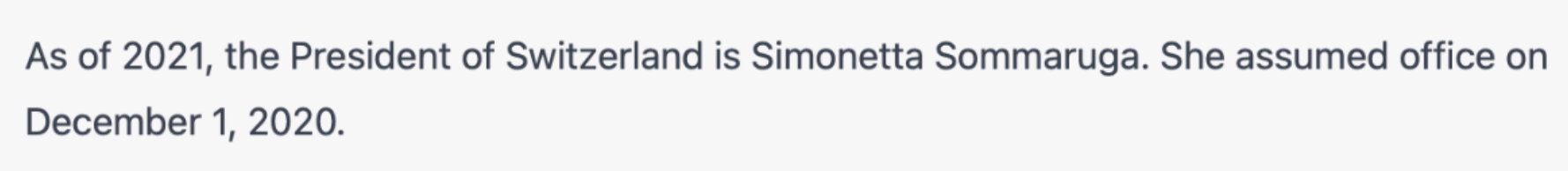

Wie im Abschnitt «Verzerrungen» erwähnt, könnte KI auf falsche Daten trainiert werden. GPT kann Texte generieren, die faktisch falsch oder irreführend sind, aber dennoch korrekt klingen, und so Fehlinformationen verbreiten.

ChatGPTs Antwort auf die Frage, wer der Präsident der Schweiz ist

Das neue Tool von OpenAI, WebGPT, wurde entwickelt, um die Genauigkeit und den Wahrheitsgehalt der von GPT-3 generierten Informationen zu verbessern, indem es auf eine breitere Palette von Quellen trainiert wird, darunter Bücher, Websites und wissenschaftliche Zeitschriften. Dies kann die Qualität der von GPT-3 generierten Informationen für eine Vielzahl von Anwendungen verbessern, darunter Chatbots, virtuelle Assistenten und Suchmaschinen. Siehe WebGPT: Improving the Factual Accuracy of Language Models through Web Browsing

Mangelndes Verständnis

GPT ist ein Sprachmodell, das nicht in der Lage ist, die Bedeutung des von ihm erzeugten Textes zu verstehen. Dies kann dazu führen, dass es unsinnige oder irrelevante Ausgaben produziert.

Datenschutz und Sicherheit

KI kann auf personenbezogene Daten abgestimmt werden, was dazu genutzt werden könnte, sensible Informationen über Einzelpersonen zu generieren, wie z. B. gefälschte Videos, Audios und Bilder, die echt zu sein scheinen. Diese Technologie, die als Deep Fakes bekannt ist, kann zur Manipulation von Informationen und zur Schaffung falscher Darstellungen verwendet werden, was zu Fehlinformationen und sogar zu Verleumdungen führen kann. Siehe auch Forecasting Potential Misuses of Language Models for Disinformation Campaigns—and How to Reduce Risk

Darüber hinaus stellen Deep Fakes ein ernsthaftes Problem für die Privatsphäre dar, da sie es jedem ermöglichen, Videos von Gesicht und Stimme einer anderen Person ohne deren Zustimmung zu erstellen. Dies kann zu erheblichen Schäden führen, da Personen ohne ihr Wissen oder ihre Zustimmung in kompromittierenden oder illegalen Situationen dargestellt werden können. Sehen Sie sich den letzten Abschnitt unseres früheren Blogbeitrags über Deep Fakes an.

Fehlende Kontrolle

GPT kann eine breite Palette von Texten generieren, darunter auch solche, die der Nutzer möglicherweise nicht beabsichtigt oder erwartet hat.

Daher liegt die Verantwortung für Schäden, die durch KI verursacht werden, bei den Menschen, die sie entwickeln, wie in diesen Beispielen zu sehen ist. Das Potenzial von KI, Schaden anzurichten, kann durch verschiedene Faktoren wie verzerrte oder unvollständige Daten, schlechte Programmierung oder böswillige Absicht entstehen. Die Entwickler von KI müssen sicherstellen, dass ihre Technologie ethisch und verantwortungsbewusst entwickelt wird und die möglichen Auswirkungen auf die Gesellschaft berücksichtigt werden. Es ist wichtig zu beachten, dass diese Risiken nicht der KI selbst innewohnen, sondern vielmehr eine Folge der Art und Weise sind, wie sie konzipiert, entwickelt und eingesetzt wird.

Grundsätze der Regulierung

Die Verantwortung für KI liegt jedoch nicht nur bei den Entwicklern. Es ist auch Aufgabe von Regierungen und Organisationen, die Entwicklung und den Einsatz von KI zu regulieren. Die Regulierung sollte darauf abzielen sicherzustellen, dass KI auf ethische Weise eingesetzt wird und dass die Technologie so entwickelt wird, dass sie der Gesellschaft als Ganzes zugute kommt. Eine Gemeinschaft, die Prinzipien vorschlägt, die als Regulierung dienen könnten, ist FAT/ML: Fairness, Accountability, and Transparency in Machine Learning.

Sie schlagen die folgenden Grundsätze für sozialverträgliche Algorithmen vor:

Verantwortung: Es sollten nach aussen sichtbare Möglichkeiten der Wiedergutmachung für nachteilige individuelle oder gesellschaftliche Auswirkungen eines algorithmischen Entscheidungssystems zur Verfügung stehen, und es sollte eine interne Rolle für die Person bestimmt werden, die für die rechtzeitige Behebung solcher Probleme verantwortlich ist.

Erklärbarkeit: Stellen Sie sicher, dass algorithmische Entscheidungen sowie alle Daten, die diesen Entscheidungen zugrunde liegen, den Endnutzern und anderen Beteiligten in nichttechnischen Begriffen erklärt werden können.

Genauigkeit: Identifizierung, Protokollierung und Darstellung von Fehlerquellen und Unsicherheiten im gesamten Algorithmus und seinen Datenquellen, so dass die erwarteten und schlimmsten Auswirkungen verstanden werden und in die Verfahren zur Schadensbegrenzung einfliessen können.

Überprüfbarkeit: Ermöglichen Sie es interessierten Dritten, das Verhalten des Algorithmus zu untersuchen, zu verstehen und zu überprüfen, indem Sie Informationen offenlegen, die eine Überwachung, Überprüfung oder Kritik ermöglichen, u. a. durch Bereitstellung einer ausführlichen Dokumentation, technisch geeigneter APIs und zulässiger Nutzungsbedingungen.

Fairness: Sicherstellen, dass algorithmische Entscheidungen keine diskriminierenden oder ungerechten Auswirkungen haben, wenn sie zwischen verschiedenen demografischen Gruppen (z. B. Rasse, Geschlecht usw.) verglichen werden.

Quelle: https://www.fatml.org/resources/principles-for-accountable-algorithms

Diese Grundsätze sind auch in unseren Grundwerten bei Renuo verankert: Verantwortung, Fairness und Transparenz und Miteinander.

Wie bereits erwähnt, liegt die Verantwortung für jeglichen Schaden, der durch KI verursacht wird, letztlich bei den Menschen, die sie entwickeln und einsetzen. Das bedeutet, dass wir bei Renuo der Meinung sind, dass es in unserer Verantwortung liegt, sicherzustellen, dass jede von uns entwickelte KI-Technologie ethisch vertretbar und verantwortungsbewusst ist und einen positiven Einfluss auf die Gesellschaft hat. Wir glauben auch an die Entwicklung von KI-Systemen, die frei von Vorurteilen sind und alle Menschen fair und gleich behandeln.

Transparenz ist auch bei der Entwicklung und dem Einsatz von KI von entscheidender Bedeutung. Es ist wichtig, dass die Funktionsweise eines KI-Systems transparent ist und von Benutzern, Regulierungsbehörden und der Öffentlichkeit verstanden werden kann. Wir bei Renuo legen grossen Wert auf die Transparenz unserer KI-Systeme, damit alle Beteiligten verstehen können, wie sie funktionieren und wie Entscheidungen getroffen werden.

Fazit

KI ist nicht von Natur aus gefährlich, aber die Art und Weise, wie sie entwickelt, eingesetzt und reguliert wird, kann Risiken für die Gesellschaft mit sich bringen, und deshalb ist ein verantwortungsvoller Ansatz für ihre Entwicklung und Nutzung von entscheidender Bedeutung.

Es ist wichtig festzuhalten, dass die Singularität zwar eine Möglichkeit ist, aber nicht unbedingt ein Weltuntergangsszenario, und es liegt an uns, dafür zu sorgen, dass KI zum Nutzen der gesamten Menschheit eingesetzt wird. Bei der weiteren Entwicklung und dem Einsatz von KI müssen wir ihre potenziellen Auswirkungen auf die Gesellschaft im Auge behalten und zusammenarbeiten, um sicherzustellen, dass ihre Vorteile maximiert und ihre Risiken minimiert werden.

We cannot argue that a pedestrian detector is safe simply because it performs well on a large data set, because that data set may well omit important, but rare, phenomena (for example, people mounting bicycles). We wouldn’t want our automated driver to run over a pedestrian who happened to do something unusual.

As an AI language model, I don't have personal beliefs or opinions. The singularity is a hypothetical concept that is still being debated and researched by experts in the field. While some experts believe that it is a possibility, others are more sceptical about the idea. Ultimately, the future of AI and the possibility of a singularity is uncertain and depends on numerous factors, including ongoing research, technological advancements, and societal developments.