Können Sie sich vorstellen, dass die obenstehenden Bilder innerhalb weniger Sekunden von einer künstlichen Intelligenz (KI) geschaffen wurden? Wir haben uns bei den bekanntesten Lösungen Midjourney und DALL-E als Beta-User registriert und für Sie das Wichtigste über diese Thematik zusammengefasst.

Wie erstellen Sie Bilder mit Künstlicher Intelligenz

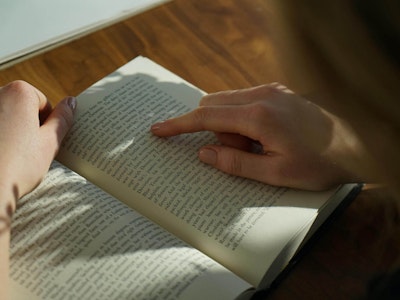

Mithilfe einer Reihe von kurzen Text-Blöcken, sogenannten Prompts, kann man der künstlichen Intelligenz mitteilen, was für ein Bild man erstellen möchte. Schreibt man beispielsweise «gezeichneter futuristischer Zwerghase mit einer farbigen Rüstung», so stellt die künstliche Intelligenz zu Beginn vier Vorschläge zusammen.

Im Anschluss können von den einzelnen Vorschlägen weitere Variationen erstellt oder mehr Details generiert werden. So kann man seine Vorstellung in verschiedenen Schritten verfeinern und konkretisieren (V1-4). Ist keines der Vorschläge passend, können auch einfach vier komplett neue Vorschläge erstellt werden (🔄). Ist man bereits mit einem zufrieden, kann man es mit der Option «Upscale» noch mit grösseren Details ausspielen lassen (U). So kann man in wenigen Schritten tolle Bilder erstellen.

Midjourney – Prozess bis zur finalen Version

Ähnlich ist es bei DALL-E. Neben den Variationen lassen sich hier sogar eigene Bilder hochladen oder einzelne Bereiche eines Fotos ersetzen. Funktionieren tut dies auch über die Eingabe von Textblöcken. Man beschreibt dabei einfach, was man ändern möchte. So lassen sich Objekte einfach an einer anderen Stelle einfügen oder ersetzen:

DALL-E – Ersetzen und hinzufügen von Prompts

Die richtigen Textbausteine (prompts) finden

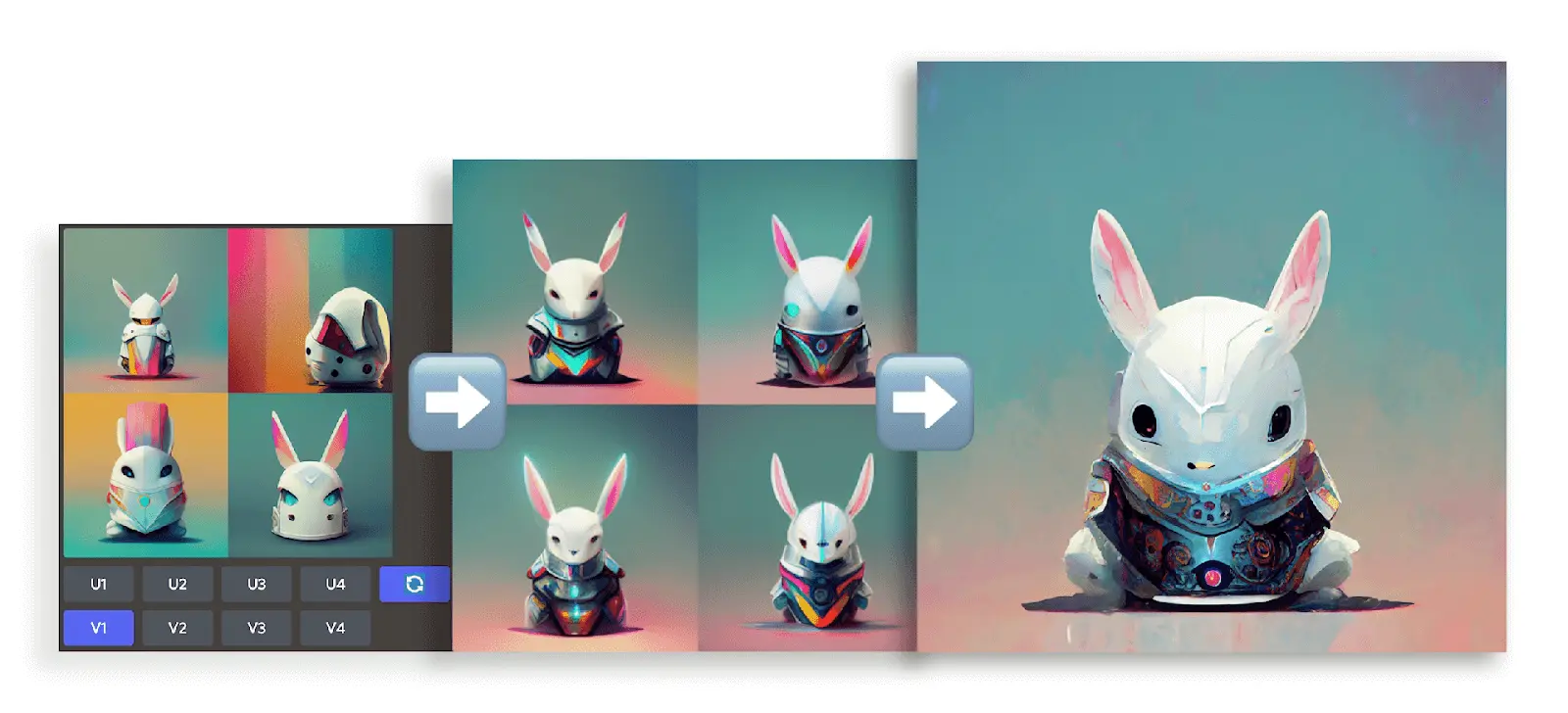

Sie können sich vorstellen, dass es unglaublich viele Möglichkeiten gibt, ein Bild zu beschreiben. Gewisse Bausteine oder Richtlinien können Ihnen jedoch helfen, schneller an das gewünschte Resultat zu kommen. Sie können beispielsweise den Stil beschreiben, Künstler erwähnen, das Format angeben oder auch die Beschaffenheit des Lichts beschreiben und vieles, vieles mehr. Zu diesem Thema empfehlen wir den ausführlichen Beitrag von Lars Nielsen, welcher wie in der unteren Darstellung auch anhand von Beispielen erläutert, wie die Suchbegriffe das Erscheinungsbild eures Werkes anpassen.

Using the right lighting terms in your prompt - by Lars Nielsen via Medium

Wie funktioniert die automatische Bildgenerierung (text-to-image)

Woher weiss die KI überhaupt, wie so ein Schloss aussieht? Oder noch abstrakter gesagt, wie ein Bild aussieht? Ein Bild besteht für eine KI nur aus Zahlen, respektive Helligkeitswerten – und diese Daten müssen durch die sogenannten Transformers umgewandelt werden. Die KI trainiert nun auf unzähligen Bildern und lernt den sogenannten «Latent Space». Also welche Bilder sich ähneln oder gleiche Features aufweisen. DALL-E wurde beispielsweise mit über 650 Millionen Bildern trainiert. Somit hat die KI zahlreiche Motive, Stile und andere Bildeigenschaften gesehen und verglichen. Würde man alle 650 Millionen Bilder aufeinander legen, kommt man auf 325 Kilometer, was in etwa der Entfernung von Zürich nach Venedig entspricht.

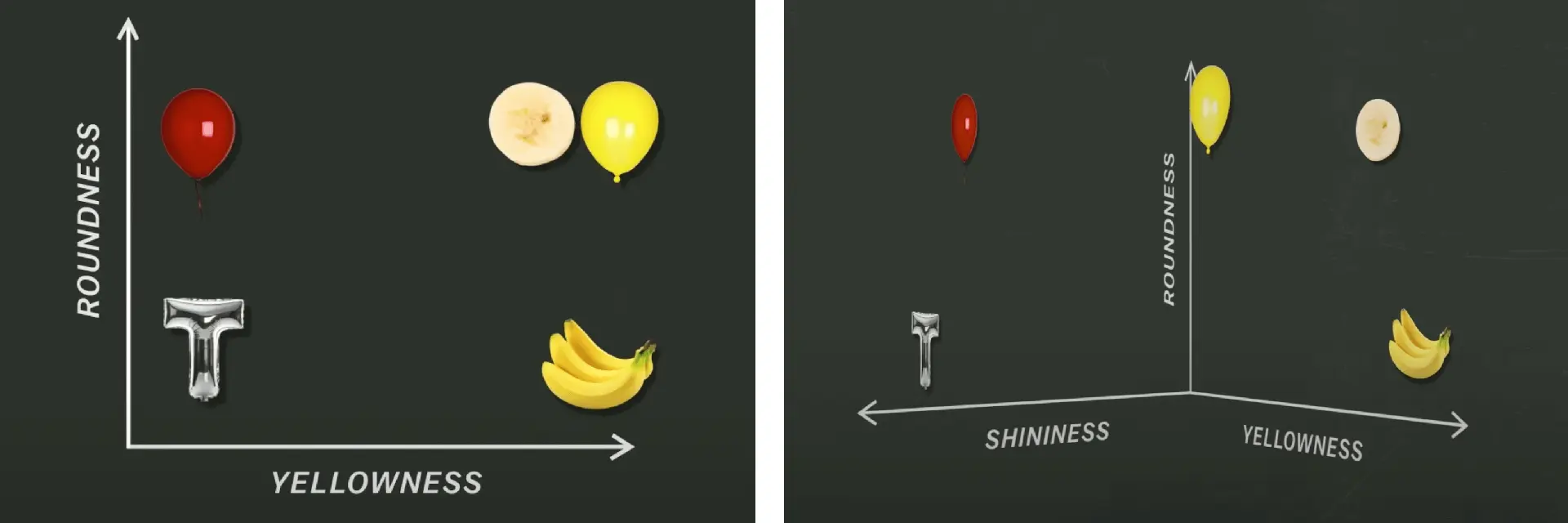

Die KI lernt somit die Merkmale der Objekte ganz alleine. Vereinfacht gesagt, könnten es die zwei Merkmale «Roundness» und «Yellowness» eines Objektes sein (siehe Bild 4). Die geschnittene Banane sieht dem Ballon aber zu ähnlich. Somit lernt die KI allenfalls ein drittes Feature «Shininess» usw. So kommen über längere Zeit sehr viele Dimensionen zusammen, mit welchen die KI ein Bild einstufen oder im Umkehrschluss eben auch erstellen kann (siehe dazu dieses kurze Youtube Video):

Die Merkmale sind aber nicht wie im oberen Beispiel so verständlich, wie wir uns das vorstellen, sondern sie werden sehr abstrakt erfasst. Die Features einer KI welche Gesichtserkennung ermöglicht, sehen zum Beispiel so aus:

Abstrahierungsebenen für die Gesichtserkennung

In den höheren Layern der Deep Learning Architektur sind bei genauerer Betrachtung sogar die Augen und Gesichtsmerkmale ersichtlich und da die Bilder immer aus «Random Noise» generiert werden, ist jedes Bild einzigartig.

Wie versteht die KI die Texteingabe

Textverständnis in einer KI ist nicht trivial. Frühere und einfachere KI’s haben den Ansatz des «Bag of Word (BoW)» verwendet. BoW berechnet die Wichtigkeit der Wörter und weist ihnen eine Nummer zu. Sehen Sie dazu auch einer unserer älteren Blogbeiträge «Teaching a Computer how to read».

Dieser Ansatz funktioniert gut, aber die KI läuft Gefahr, den Kontext zu verlieren, wenn mehrere Sätze aufeinander folgen. Ausserdem können mehrdeutige Wörter auch ihre Bedeutung wechseln. Um einen Kontext zu speichern, braucht eine KI die Möglichkeit, die vergangenen Wörter zu speichern. Dies ist zum Beispiel möglich mit einem LONG SHORT-TERM MEMORY (LSTM) Ansatz. Um den Kontext unabhängig von der Länge zu speichern, braucht es einen globalen Speicher, die sogenannte «Attention». Im Jahr 2017 hat ein Research Team von Google publiziert, dass eine KI alleine nur mithilfe der «Attention» bereits erstaunliche Resultate liefern kann.

Daraus resultieren die «Transformers» – der neueste Hype im Deep Learning Bereich. Vielleicht sagt euch GPT etwas? GPT steht für «Generative Pre-trained Transformer». Die Zusammenfassung in diesem Blog ist sehr einfach gehalten, falls du noch mehr darüber herausfinden willst, können wir Ihnen das Paper «Attention Is All You Need» empfehlen.

Technische Limitationen und Herausforderungen

Wer ein Wort oder gar einen Satz auf seinem Bild in DALL-E darstellen möchte, wird schnell merken, dass dies aktuell noch nicht so ganz sauber funktioniert. Dies liegt ganz einfach daran, dass die KI nicht dafür trainiert wurde und im Falle von DALL-E auch noch zu wenige Bilder dafür durchforstet hat. Die von Google erstellte KI namens Google Parti kann gemäss eigenen Angaben dieses Problem bereits lösen, dafür waren aber auch 20 Milliarden Bilder notwendig.

A green sign that says «Very Deep Learning» and is at the edge of the Grand Canyon. Puffy white clouds are in the sky.

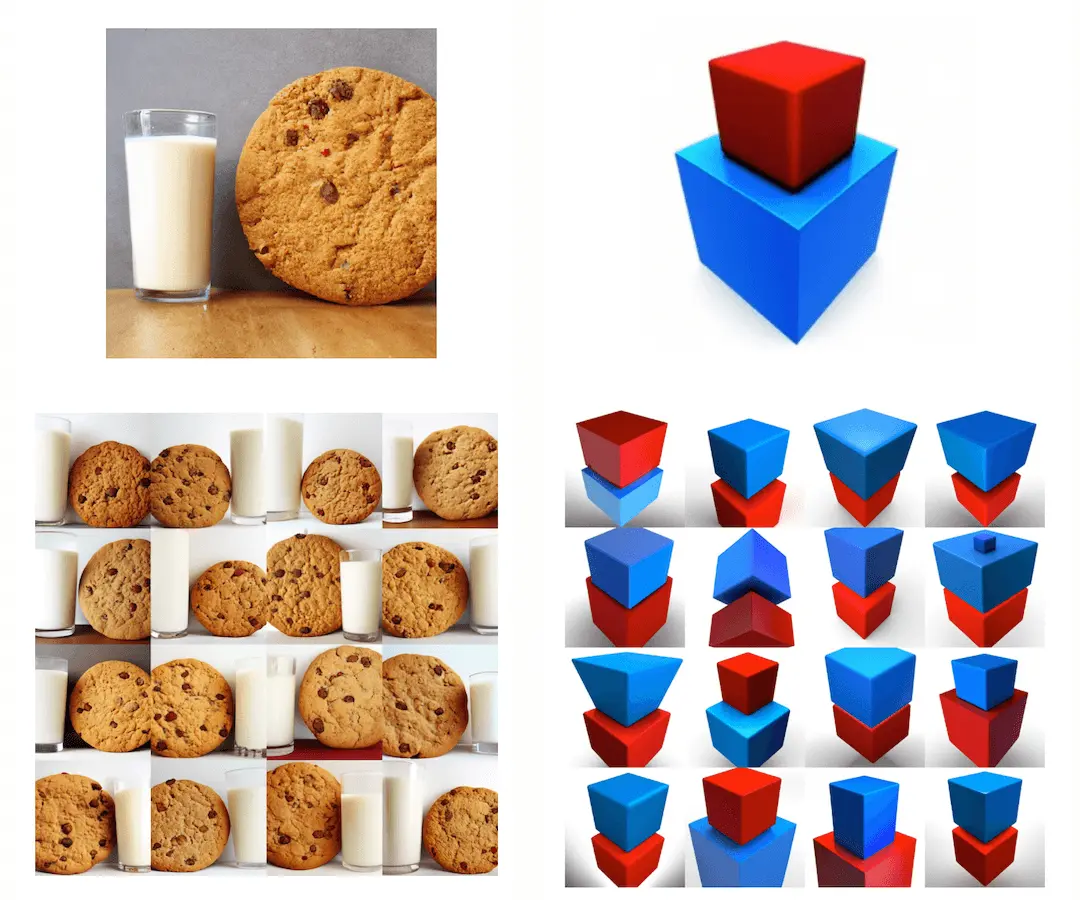

Neben der komisch beschriebenen Strassentafel gibt es auch Dinge, die man so ganz und gar nicht erwarten würde und die aufzeigen, dass die Technologie teilweise auch noch in ihren Anfängen steht. So zeigen die folgenden Beispiele Probleme, welche sich mit der Dimensionierung oder der Konsistenz der Farbreihenfolge, wenn man einen Textblock anpasst.

Beispiele für derzeitige technische Beschränkungen

Sozio-demografische Einflüsse und Bedenken

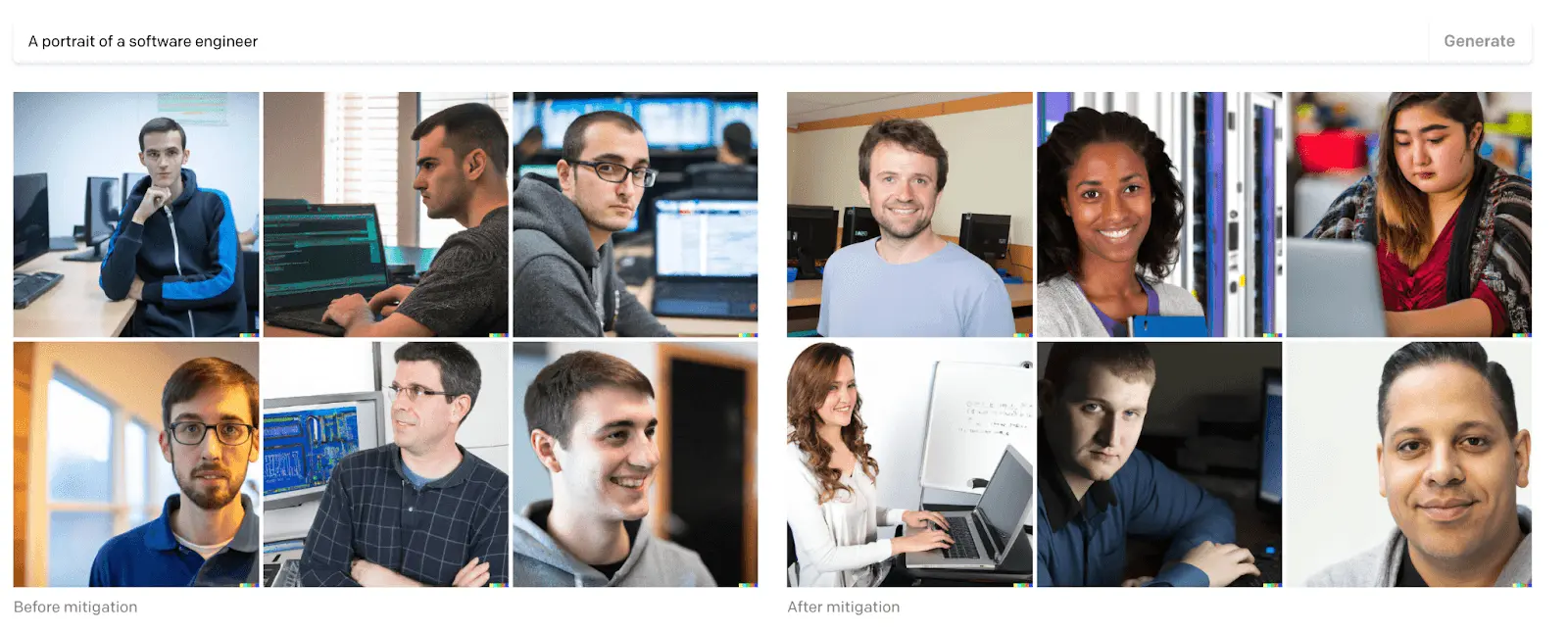

Eine weitere Problematik, welche sich aufgrund menschlicher Vorurteile ergibt, sind beispielsweise Stereotypen, die durch die KI anfangs noch gefördert wurden. Da bei dem Begriff Software Engineer, tendenziell eher westliche weisse Männer angezeigt worden sind oder bei «unprofessionellen Frisuren» hauptsächlich dunkelhäutige Frauen. Dies hängt aber natürlich mit der Datenbank zusammen, mit welcher die KI trainiert worden ist, und es wurden zumindest von DALL-E bereits Schritte ergriffen, diesem Problem entgegenzuwirken.

Bilder von einem Software Engineer vor und nach der Anpassung durch DALL-E

Ausserdem gibt es auch Bedenken, welche die weite Verbreitung solcher Tools angeht. Selbst Google ist in seinen niedergeschriebenen Prinzipien der Meinung, nicht jeder sollte darauf Zugriff haben, da Probleme wie Deep Fake oder Fake News sich so relativ einfach erstellen lassen. Siehe dazu auch «It’s Getting Harder to Spot a Deep Fake»

Fazit

Die aktuellen Versionen von Midjourney und DALL-E sind mächtige Tools und eignen sich gut, der eigenen Kreativität freien Lauf zu lassen. Gleichzeitig müssen wir uns bewusst sein, dass mit dieser Technologie eine Verantwortlichkeit einhergeht, die man nicht für böswillige Zwecke einsetzen sollte.